2025, az utolsó "normális" év?

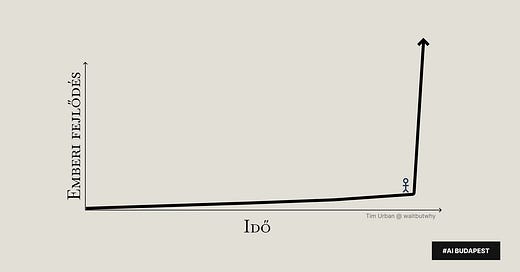

Az exponenciális fejlődés különös tulajdonsága, hogy sokáig észrevétlen marad, majd hirtelen minden megváltozik körülöttünk. A jelek szerint most egy ilyen pillanatban vagyunk.

10 éve publikálódott az egyik leghíresebb poszt a mesterséges intelligenciáról, a méltán híres wait but why blogon. A cikk ezzel a - sokatok számára már biztosan ismerős - képpel kezdődik. Emlékszem, hogy amikor először láttam, elég kényelmetlenül éreztem magam tőle. Emberünk ott áll a függőlegesen kirobbanó nyíl, az exponenciális fejlődés árnyékában:

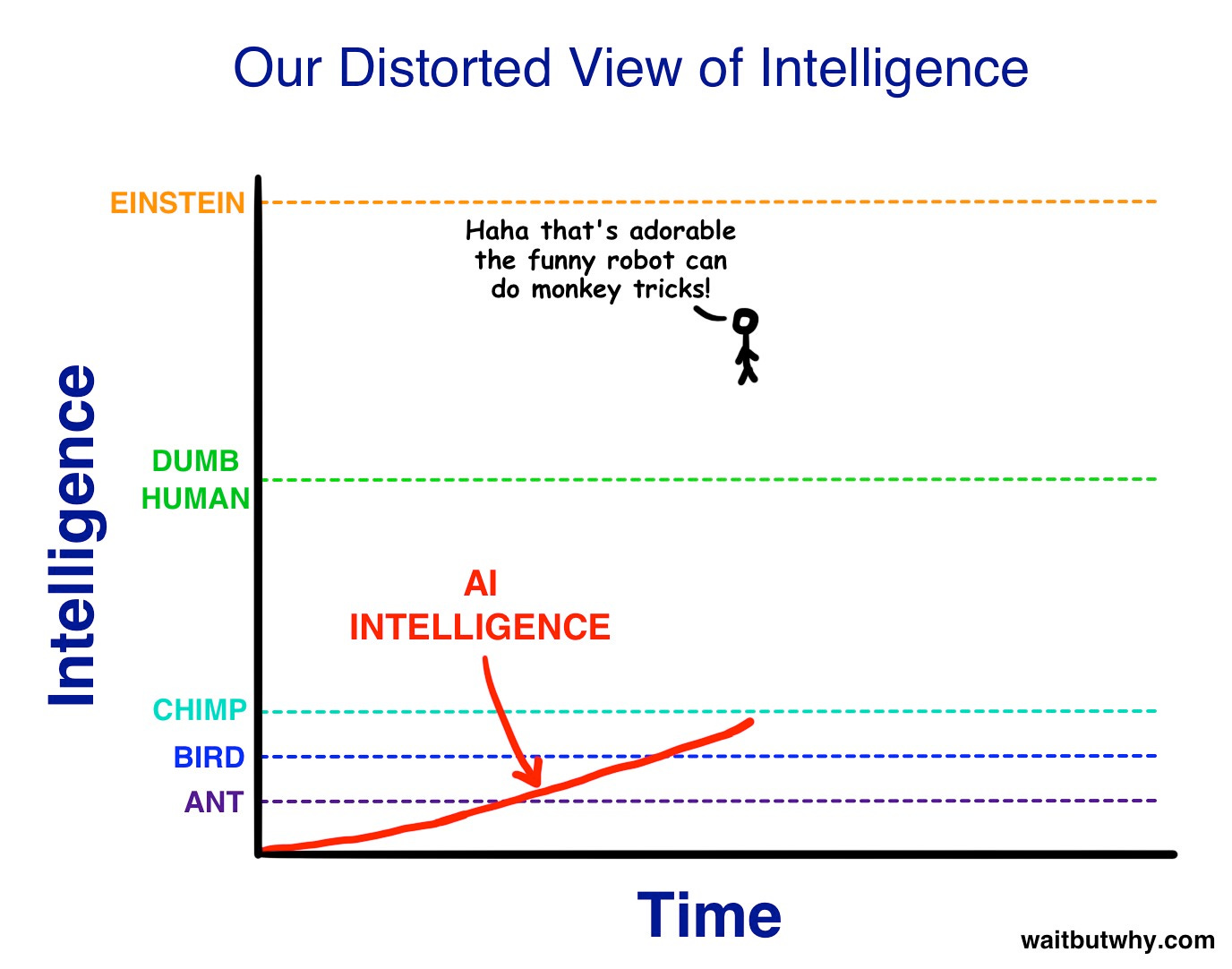

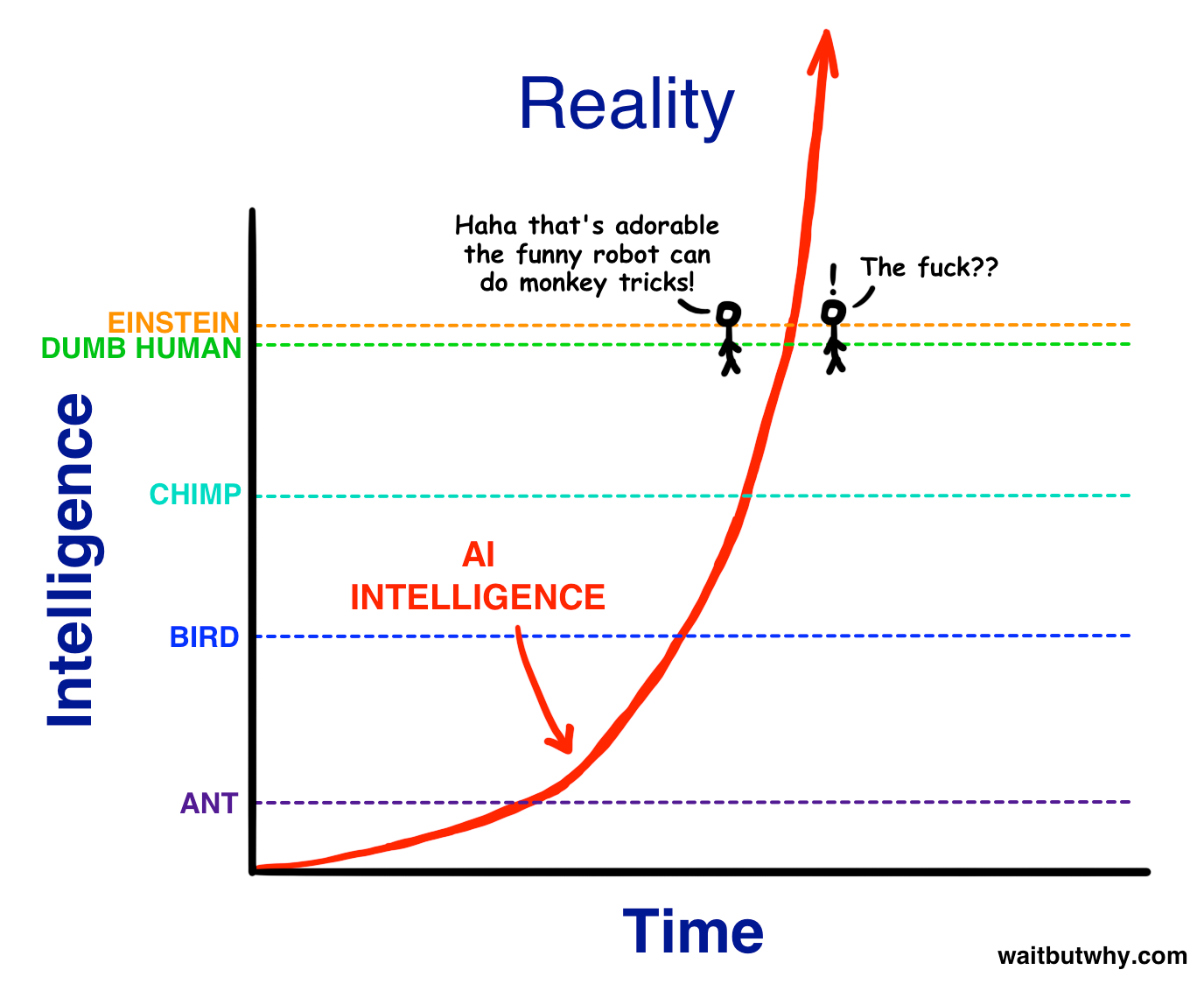

Azt is hamar megtudjuk a cikkből, hogy igazából a valóság ehhez képest nem is így néz ki, hiszen csak a múltat látjuk mögöttünk, előre semmit. A helyzet valójában ez:

Nektek milyen érzés itt állni? Nekem még kényelmetlenebb, érzem, hogy feszengek a helyemen. Van valami igazán erős abban, ahogy Tim Urban ilyen egyszerűen tud vizualizálni ilyen komplex témákat.

Mivel nem tudjuk megjósolni a jövőt, ezért igazából a beszélgetés az optimisták és pesszimisták vitájára szűkül. Nagy mondások, értelmezések, gondolatok csatája lesz. Bárhogy is alakul ez a beszélgetés, bárki is érzi azt, hogy neki van igaza, igazából az éppen aktuális változásokból tudunk csak kiindulni, illetve a múltból következtetéseket levonni - valahogy épp így:

A távoli jövő hamarabb érkezik, mint gondolnánk.

Ray Kurzweil, a híres jövőkutató évtizedek óta beszél a "Gyorsuló Megtérülés Törvényéről". Az elmélet arról szól, hogy minél fejlettebb egy társadalom, annál gyorsabban tud tovább fejlődni -> ezért nem lehet a múltból kiindulva megjósolni a jövőt.

Tim azt a példát hozta, hogy képzeljük el, hogy időgéppel visszamegyünk 1750-be, és elviszünk valakit a cikk írásakori jelenbe, azaz 2015-be. Szegény valószínűleg azonnal szörnyethalna - képtelen lenne feldolgozni az internetet, az okostelefonokat, a repülőgépeket, és még sorolhatnánk. És akkor még nem is arról beszéltünk, hogy mi lenne vele, ha most érkezne közénk, és valaki a kezébe nyomna egy ChatGPT voice módot.

De ha ő is hasonlóan szeretne sokkolni valakit, visszamenne ugyanennyit az időben, és elhozna valakit 1500-ból 1750-be? Az illető biztosan le lenne döbbenve, de abszolút nem lenne számára akkora sokk, mint neki volt: az 1500 és 1750 közötti változás, bár jelentős, közel sem olyan sokkoló, mint az 1750 és 2025 közötti.

Tim ezt a "halálos sokk" mértéket használja a fejlődés sebességének mérésére - Halálos Fejlődési Egység (HFE). Milyen drámaian hangzik. Ráadásul ezek az egységek egyre rövidebb idő alatt következnek be. A vadászó-gyűjtögető embernek még 100,000 évet kellett volna előreutaznia egy HFE élményhez, akarom mondani sokkhoz. A középkor emberének már "csak" 12,000 évet. Egy 1750-ben élő személynek pedig elég ideutaznia 2025-be.

A Gyorsuló Megtérülés Törvénye alapján a 21. században 1000x akkora fejlődést érünk el, mint a 20. században Ha Kurzweilnek igaza van, akkor a 2015 és 2030 közötti változástól ugyanúgy le leszünk döbbenve, mint az 1750-es időutazónk 2024-ben - vagyis a következő "halálos sokk" már nem századokat vesz igénybe, csak évtizedeket.

Mi lehetünk az első generáció, akinek lehet nem kell időutazónak lennünk ahhoz, hogy megtapasztaljon egy Halálos Fejlődési Egységet.

Ez nem science fiction, mese, kitaláció, összeesküvéselmélet - ha megnézzük a történelmet, logikusan is erre kéne számítanunk.

Akkor mégis miért van az, hogy nem igazán hisszük el, ha azt halljuk, hogy "a világ 25 év múlva teljesen felismerhetetlen lesz"?

Miért nem látunk tisztán előre?

Három oka van, hogy miért vagyunk szkeptikusak a jövő ilyen előrejelzéseivel kapcsolatban:

1. Egyenes vonalban gondolkodunk

Amikor a jövőről gondolkodunk, automatikusan vonalzót fektetünk a múltra. "Az elmúlt 30 évben ennyit fejlődtünk, szóval a következő 30-ban is nagyjából ennyit fogunk" - gondoljuk. Ennél egy fokkal jobb az a mondás, hogy: "Nézzük inkább a jelenlegi fejlődési ütemet, és számoljunk azzal!" De még ez is kevés. A helyes gondolkodáshoz el kéne képzelnünk, hogy a fejlődés sokkal, de sokkal gyorsabb lesz, mint amit most látunk. Exponenciális. Csakhogy ezt az agyunk nem tudja értelmezni, ráadásul a múlt alapján őrültségnek, irracionálisnak tűnik.

2. A közelmúlt becsapós

Képzeld el, hogy egy hatalmas kör egy nagyon kis szeletét nézed közelről. Szinte egyenes vonalnak tűnik, nem? Na, pont ez van a fejlődéssel is. Ránézünk az elmúlt pár évre, és azt hisszük, látjuk a teljes képet, pedig nem is. A fejlődés nem egyenletes - Kurzweil szerint "S-görbékben" halad. Mint amikor megtanulsz valamit: először lassan megy, aztán hirtelen beindul, végül pedig ellaposodik... amíg el nem kezdesz valami újat tanulni. Ráadásul ez nem áll meg, folytatódik - a háttérben már készül a következő ugrás, ami még nagyobb lesz, mint a korábbi.

3. A tapasztalataink csapdájában vergődünk

A személyes tapasztalataink alapján alkotunk képet a világról, és ez a kép azt súgja: "a dolgok úgy változnak, ahogy eddig is változtak". A fantáziánk is ebből, az eddig megtapasztalt élményanyagból dolgozik, amikor a jövőt próbálja elképzelni. Hiányoznak azok a még nem létező fogalmak, amikkel egyáltalán el tudjuk képzelni a jövőt.

Na, de 10 év táblatából működött a predikció?

Kurzweil azt jósolta, hogy 2025-re (idénre) ezer dollárból olyan számítógépet vehetünk majd, ami az emberi aggyal egyenértékű számítási kapacitással bír. Most, 2025-ben abban a szerencsés helyzetben vagyunk, hogy megnézhetjük, mennyire jöttek be Kurzweil jóslatai - avagy akasztják a hóhért.

Ha csak ezt nézzük, csalódnunk kellene - a prediktált 1000x növekedés mindössze 3.3%-át értük el. Akkor nem is igaz ez az egész “Gyorsuló Megtérülés Törvénye?

Egy szempontból jogos a csalódás, hiszen nem jött be a konkrét predikció. Viszont emlékeztek a korábban említett 3. pontra? Kurzweil ugyanúgy beleesik azokba a saját csapdákba, amikről ő maga ír, a jelenben ragadott meg egy jelenséget, és abban a témában várt exponenciális növekedést. Bár nagy előrelépések voltak számítási kapacitás növekedésben is, az igazi technológiai változások más területeken történtek:

Vegyük például a számítási sebességet. A Google Willow kvantumszámítógépe 2024 decemberében például olyan feladatot old meg 5 perc alatt, amihez a világ jelenlegi legerősebb szuperszámítógépének 10,000,000,000,000,000,000,000,000 évre lenne szüksége. (Ez 10 szeptillió év - az univerzumunk 13.8 milliárd éves korához képest. Egy ideje próbálom ezt aggyal felfogni, de még nem sikerült.) Szóval, nem 1000-szeres fejlődést történt sebességben 10 év alatt, hanem itt a most elérhető legerősebb szuperszámítógéphez számítási sebességéhez képest történt egy ki sem tudom számolni mekkora ugrás. És ezt az ugrást nem óriási számítási kapacitással érte el, hanem egy teljesen új megközelítéssel, mindössze 105 qubittel. [nekem is rá kellett keresnem] Ez nem exponenciális fejlődés. Ez dupla exponenciális - egy olyan technológiai ugrás, amit Kurzweil is nehezen tudott volna elképzelni 2015-ben. Nem azért, mert rosszul gondolkodott a fejlődés természetéről, hanem mert ő is - mint mindannyian - a már ismert technológiák fejlődését próbálta előrejelezni.

Ez történt a Generatív AI esetében is. Miközben mindenki a számítási kapacitást és sebességet figyelte, 2017-ben csendben megjelent egy tanulmány "Attention is All You Need" címmel. A benne leírt transformer architektúra nem követelt extrém számítási kapacitást - "csak" egy teljesen új megközelítést hozott a gépi tanulásba. Ez indította el azt a robbanást, ami a ChatGPT-n keresztül vezetett odáig, hogy most épp a Claude-dal gondolkodok közösen a cikk írásán. Azzal a Claude-dal, ami egyeseknek AGI élményt okoz.

Az eredeti transformer architektúra tehát nem csak egy új technológiai megoldás volt - hanem egy új paradigma. Nem pont úgy értük el a célt, ahogy Kurzweil előre jelezte. Miközben a széles körben elérhető klasszikus számítási kapacitásban elmaradtunk a várakozásoktól, egy teljesen új irányból érkeztünk meg egy hasonló - vagy talán még izgalmasabb - pontra.

[Nagyon érdekes, hogy Tim ezt a cikket még a Generatív AI korszak előtt írta. Az AI fejlődési útját akkor egyszerűnek látta: az ANI-tól egyenesen az AGI felé haladunk. Most itt vagyunk 2025-ben, egy átmeneti időszakban: az AI már brutális dolgokra képes, miközben továbbra is "csak" egy specializált eszköz - hallucinál, korlátozott kontextussal dolgozik, és alapvetően szavakat rakosgat egymás után. De pont ez teszi izgalmassá ezt a korszakot: élőben figyelhetjük, ahogy egy új technológia az S-görbe közepén száguld felfelé]

Út az AGI felé.

Tim 10 éve három lehetséges utat vázolt fel az AGI felé:

1. az agy másolását,

2. az evolúció szimulálását,

3. és azt, hogy hagyjuk az egészet a gépekre - tanítsuk meg őket, hogy fejlesszék saját magukat.

A Generatív AI már az első két megközelítésből egyértelműen építkezik: a transformer architektúra az agy figyelmi mechanizmusait másolta, a nagy nyelvi modellek pedig evolúciós jellegű tanulással fejlődnek, hatalmas adathalmazokon "szelektálódva". Sokáig úgy tűnt, hogy a valódi öntanulás és önfejlesztés képessége még messze van, 2025 elején ez a feltételezés is megdőlni látszik:

A kínai DeepSeek új modellje, az r1, ebben is ijesztően impresszív: ez az első olyan nagy nyelvi modell, ami tisztán megerősítéses tanulással (reinforcement learning) képes fejlődni, minden előzetes felügyelt tanítás nélkül.

Az r1 nem csak tanul, hanem aktívan fejleszti is magát: képes az önellenőrzésre és a reflexióra, sőt, a kutatók meglepetésére olyan összetett viselkedésformákat is kialakított, amiket nem programoztak bele.

A számok pedig most kezdenek igazán érdekessé válni. Mert míg a klasszikus számítási kapacitás önmagában nem volt elég az áttöréshez, most, hogy megvan a hatékony architektúra és az öntanulási képesség, a növekvő számítási kapacitás új dimenziókat nyithat meg - és akár ez lehet a hatalom új formája is.

Éppen most húz el mellettünk, csak nem vesszük észre?

Az AI számára az "emberi szintű intelligencia" nem egy fontos mérföldkő - ez csak nekünk tűnik annak. Olyan lesz ez, mint amikor egy autó áthalad a 40 km/h-s sebességen - a ló maximális sebességén. Nem fog lelassítani, hogy megünnepelje a pillanatot.

Mi most pont ezt éljük át. Azt hisszük, hatalmas a különbség Einstein és egy átlagember intelligenciája között. De az intelligencia teljes spektrumában az összes ember - a legbutábbtól a legokosabbig - egy meglepően szűk sávban helyezkedik el. És az AI épp most száguld át ezen a sávon.

Egészen pontosan így nézünk most ki: a 4o már olyan intelligenciaszintet mutatott, amivel az emberiség top 17%-ba tartozott a modell. Az o1 okosabb, mint az emberek 99%-a. Ehhez képest hogy teljesít az OpenAI legújabb reasoning modellje, az o3? Olyan IQ szinttel rendelkezik, amivel csak az emberiség 0.0075%-a. Ez már vészesen közelít a sárga Einstein sávhoz, onnantól pedig to the infinity and beyond.

Hoztam egy chartot az elmúlt 6 évről, ami a mesterséges intelligencia modellek ARC-AGI teszten elért eredményeit mutatja - ez talán az eddig ismert legjobb, leghitelesebb teszt az általános intelligencia mérésre. A december erősen karcosra sikerült:

Annyira erősre, hogy gyakorlatilag az összes létező benchmark-unkat dobta a kukába, új tesztek, benchmarkok, megközelítések kellenek. Ilyen például az “Az Emberiség Utolsó Vizsgája” teszt, ami 3000 elképesztően nehéz kérdést tartalmaz analitikus filozófiától rakétatechnikáig.

A teszt készítői azt jósolják, hogy év végére lesz olyan model, ami 50%-ot fog elérni. Aztán hamarosan elérünk a 100%-hoz. Ami azt jelenti majd, hogy a legokosabb ember sem képes olyan kérdést feltenni, amire ne lenne képes egy AI modell, legyen szó bármilyen nehéz területről. Ami pedig azt jelenti, hogy átléptük azt a határt, ameddig meg tudjuk ítélni egy AI modell intelligenciáját. Kifogytunk az emberi benchmarkokból. Az új paradigma teljesen új megközelítést kíván majd meg. És emlékeztek arra a részre, hogy ez igazából csak nekünk fontos mérföldkő? Nem lesz semmilyen megállás ezen a ponton, robogunk tovább.

[02.03 edit: a 10 napja megjelent “Az Emberiség Utolsó Vizsgája” nevű teszten az o1 Pro azonnal 9.1%-ot ért el, pár napra rá az o3 mini már 13.3%-ot, tegnap pedig a deep research már 26.6%-ot, szóval lehet nem kell itt év végéig várni az 50%-kal]

De mi is ez az o3, és hogy jutottunk ide?

Az OpenAI adventi calendar, (12 nap - 12 bejelentés) sorozatának első napján jelentették be az o1 teljes release-t és az o1 Pro előfizetés, a 12.-napon pedig bemutatták az o3 modelljüket. 12 nappal az o1 Pro után. Nem csak a teljesítmény sokkoló ebben, de a sebesség, amilyen gyorsan mindez történt.

Ráadásul miközben már az o3 a téma, az emberek nagy része még az o1-et sem tudja rendesen használni. De mi is ez az egész "o" család? Sokan nem is értik a különbséget: ez nem csak egy újabb chat modell, hanem egy új megközelítés - a reasoning model egy olyan kolléga, aki a elvonul a kérdéseddel gondolkodni, és csak alapos megfontolás után válaszol. Konkrét problémáknál (mint egy matekpélda vagy kódolási feladat) zseniális, míg általános, nyitott beszélgetéseknél sokszor jobb maradni a hagyományos modelleknél. Ez persze más típusú kommunikációt is igényel: a beszélgetés-szerű iterálás helyett sokkal fontosabb a pontos feladatleírás.

Az AI lab-ek folyamatosan dobják ki az újabbnál újabb, jobbnál jobb modelleket, és bár benchmarkokkal tudjuk valahogy mérni őket, az igazi használhatóságuk tesztelésében már most jelentősen le vagyunk maradva. Pedig ez csak gyorsulni fog. Egy példa erre: december 18.-án épp megalakult egy többszáz akademikust, kutatót tartalmazó kezdeményezés, akik elkezdték tesztelni közösen az o1 modell tudományos használhatóságát, első körben úgy, hogy 100 tudományos kutatást vizsgálnak meg a modellel, hátha találnak benne bármilyen számítási, vagy következtetési hibát. Elindult a munka, erre 2 nap múlva bejelentették az o3-at, ami a benchmarkok alapján egy egészen új szintet jelent.

És akkor felmerül a kérdés:

Ha megpróbálunk minden új modellt lekövetni, sosem jutunk el alapos tesztelésig. Ha viszont egy modellre koncentrálunk, menthetetlenül lemaradunk a fejlődésről.

Érdekes megfigyelni a charton a 4o és az o3 közötti különbséget: a kb 7 hónapja megjelent 4o szinte nem is látszik! Az a 4o modell, amit szerintem a legtöbben AZ AI-nak ismerik, mivel szerintem ezt a modellt használják jelenleg a legtöbben, ezért ez alapján ítélik meg az AI jelenlegi képességét. (Ezt használják az ingyenes ChatGPT-ben a magánszemélyek, illetve a Copilotban az üzleti felhasználók is - bár erre nem találtam részletes kimutatást, szóval ezt csak kezeljük feltételezésként.)

Szóval épp elszáguld mellettünk az intelligencia, miközben az emberek nagy része épp macskás képeket, vicceket, vagy éppen hiányos email összefoglalókat készít, és arról beszélnek, hogy hogy lenne már intelligens, hiszen összevissza hallucinál. Emlékeztek még az S görbére?

Változott a hangulat

Érdekes, hogy hogy változott meg a Twitteren/X-en a hangulat. November még a “deep learning hit the wall” című vitáról szólt, azaz arról, hogy falba ütközött a mélytanulás, nincs több adat, nem lesz innentől semmilyen ugrás, nem működik a skálázhatóság a végtelenségig, kidurrant a lufi. Mondhatnánk úgy is, hogy vége van, kicsi.

A tavalyi év közepén megjelent Situational Awareness írásában Leopold Aschenbrenner 2027-re tette az AGI megjelenését. A legtöbben nem komolyan vehető mondásnak tartották ezt, annak ellenére is, hogy egészen látványosan vezette le az elméletét. Ehhez képest főleg az o3 megjelenése óta a vezető AI labek legfőbb arcai egytől egyig arról beszélnek meggyőződve, hogy valami AGI szerűség már a nagyon közeljövőben, akár már jövőre itt lehet velünk:

És ha újra bevesszük a képbe Kurzweil mondását, miszerint mindig alul prediktálunk, nem tudjuk felfogni igazán a jövőbeni fejlődés exponencialitását, érdekes világ várhat ránk: öveket becsatolni, lehet egy “Halálos Fejlődési Egység” következik.

Drámai forgatókönyvek

A ‘wait but why’ cikk második része talán még ijesztőbb, mint az első, elég csak a címét elolvasni: ‘AI forradalom: Halhatatlanság, vagy Kihalás.‘

Gondolkodtam egy kicsit azon, hogy behozzam-e ezt a gondolatot a cikk végére, mennyire veszít majd a befogadhatóságból, komolyan vehetőségből, de egyrészt elég meggyőző a gondolatmenet, másrészt pont én írtam arról a Kurzweil-i mondásról, hogy sokszor teljesen őrültségnek tűnik a jövő az adott pillanatban, ezért végül arra jutottam, hogy nem hagyhatom ki. Tim arra a következtetésre jutott, hogy ha az AI tényleg exponenciálisan fejlődik tovább, akkor az AI vagy megoldja minden problémánkat - beleértve az öregedést és a halált - vagy túl veszélyessé válik az emberiség számára. [Az első kicsit jobban hangzik, de azért ahhoz is lennének kérdéseim.]

Ha az az első reakciód, hogy na jó, eddig is furcsa volt ez a gondolatmenet, de ez aztán már tényleg túlzás, akkor egyrészről teljesen megértem. De nézzük csak meg, mit mondanak erről a területen dolgozó szakemberek: az Anthropic vezetője épp a napokban beszélt Davosban arról, hogy az AI segítségével akár 5 év alatt megduplázhatjuk a várható emberi élettartamot.

A Google DeepMind vezetője, Demis Hassabis nemrég arról beszélt, hogy az AlphaFold AI rendszerük egymilliárd évnyi PhD munkát végzett el a fehérjék szerkezetének feltérképezésében - az év végére az első, ezen alapuló gyógyszereik már klinikai tesztelés alatt lehetnek.

Az EvolutionaryScale új generatív modellje, az ESM3 viszont már nem csak elemez, hanem alkot is: egyetlen kísérletében 500 millió évnyi evolúciót szimulált, teljesen új, működő fehérjéket tervezve. (nem mondom, hogy teljesen felfogom, hogy ez mit jelent, de felírtam, mint következő feltárandó téma)

És akkor képzeljük el, mire lehet majd képes több milliárd AGI szintű ügynök, amikor együtt dolgoznak majd.

Közben a munka világában is drámai átalakulások kezdődtek. A Salesforce szintén a napokban jelentette be, hogy nem tervez idén új fejlesztőt felvenni, mert a tavaly bevezetett AI eszközök annyira megdobták a fejlesztő csapat produktivitását, hogy még ezt próbálják meg lekövetni.

Amíg Sam Altman a prosperitás megérkezéséről ír, addig egyre több (1,2) friss tanulmány érkezik arról, hogy a gyors berobbanású AGI hogyan vágná földhöz az emberi béreket.

Az utolsó pillanatban vagyunk, vagy kidurran a lufi?

Mondhatnád, hogy ez mind érdekes és izgalmas, de ott van:

1. Az infrastruktúra kérdése

Az AI fejlődésének talán legkézzelfoghatóbb korlátja a fizikai infrastruktúra. A jelenlegi modellek energiaigénye olyan mértékű, hogy a tech cégek már saját atomreaktorok építésébe kezdtek. Az USA 500 milliárd dolláros AI infrastruktúra projektet indít, Kína válasza sem fog késni - illetve a legtöbb tőkebefektetés is ebbe az irányba áramlik.

2. A technológia határai

Gary Marcus, az AI fejlődés nagy szkeptikusa gyakran emlékeztet rá: attól, hogy egy AI kimagasló eredményt ér el bizonyos teszteken, még messze van az általános intelligenciától. Ahogy a 'Humanity's Last Exam' teszt alkotói fogalmazták: 'Hatalmas szakadék van aközött, hogy valaki megold egy fizika vizsgát, vagy hogy valódi kutatást végez.'

A jelenlegi nagy nyelvi modellek még mindig küzdenek olyan alapvető kihívásokkal, mint a rövid memória vagy a töredezett tokenek problémája, de közben elkezdtek megjelenni olyan az új architektúrák - a Titan, a Transformer², vagy az Large Concept Model -, amik pont ezeket a korlátokat célozzák meg.

3. Az adaptáció kihívása

A társadalom és a gazdaság lassabban mozdul, mint a technológia - de még ezen belül is különböző sebességeket látunk. A legtöbb nagyvállalatnál a generatív AI projektek még csak pilot fázisban vannak, óvatos kísérletezés zajlik. Közben viszont már megjelentek azok a startupok, amelyek a nulláról, AI ügynökök köré építik fel teljes működésüket - ők nem a meglévő rendszereket próbálják adaptálni, hanem eleve az új paradigmában gondolkodnak.

A társadalmi adaptáció még összetettebb, bonyolultabb és nehezebb kérdés. A MAYA elv - Most Advanced Yet Acceptable - szerint csak olyan újdonságot tudunk befogadni, ami még éppen feldolgozható számunkra. De mi történik, ha a változás olyan gyors, hogy nem tudjuk lekövetni sem, nem hogy befogadhatóvá tenni a mesterséges intelligenciát? Mi lehetünk az első generáció, aki nem időutazóként, hanem a saját életében tapasztal meg egy Halálos Fejlődési Egységet - és egyelőre fogalmunk sincs, hogyan készüljünk fel erre.

Ha csak a korlátokat nézzük, pont azt ismételjük meg, amiről a cikk elején beszéltünk: a jövőt a múlt szemüvegén keresztül próbáljuk értelmezni. A távoli jövő már nem is olyan távoli - sőt, talán már itt kopogtat az ajtónkon.

És ha tényleg exponenciális változás jön, akkor nem az a kérdés, hogy lesz-e elég számítási kapacitásunk vagy energiánk.

Hanem az, hogy mi magunk készen állunk-e.

Ahogy a történelem során annyiszor, a legnagyobb áttörések gyakran nem ott és nem úgy történnek, ahogy vártuk őket. A transformer architektúra sem a nyers számítási kapacitás növekedéséből született - most is lehet, hogy miközben a jelenlegi korlátokra figyelünk, valahol már formálódik valami olyan megoldás, amit még csak elképzelni sem tudunk.

Lehet, hogy ez az utolsó időszak, amikor még mi dönthetjük el, hogyan alakuljon a történet.

Vajon hol van ebben a plató (nyilván plátói)? Mármint az emberi felfogó és befogadókèpessèg nyilván korlátolt, már ahol most tartunk is, nehéz elfogadni, vagy értékelni, hogy milyen szerepet tölt be az életünkben. Messzire vezetnek a kérdések, hogy az emberi életévek duplázása kinek elérhető, van-e értelme egyáltalán stb. Az, hogy nagy tömegek hogyan fognak megbirkózni a növekedés okozta szorongással, miként reagálnak a munkahelyek elvesztésére és milyen értékek mentén kell majd nevelni az új generációkat - már most ijesztő. Az pedig, hogy a világpolitika hogy fogja ezt (ki)használni, a jelenlegi helyzet nem a rózsás irányba mutat.

Természetesen látjuk az elképesztő, beláthatatlan ütemű fejlődést, de a helyzet az, hogy a mesterséges intelligencia még mindig nem vezet el egy autót vagy nem mossa ki a ruhákat, másfelől meg szerintem ezek egy részét egyszerűen azért nem fogja megtenni, mert maga az erkölcsiség és a jogrend az emberi ítélőképességen, akaraton, felelősségvállaláson alapul. Hogy élvezhetjük (ki mennyire fogja élvezni, az más kérdés) az eredmények egy részét, az biztos, de szerintem nem is lenne jó meg nem is reális megbízni annak a "gondolatmenetében", akit elvi szinten lehetetlen megértened.

Ha pedig ez így van, könnyen járhatunk úgy, mint a Mátrixban. De ez is csak egy predikció, és általában ezek a predikciók egyáltalán nem a lényegre szoktak fókuszálni. Itt is nagyon komoly anyagi érdekek vannak.

Egy megjegyzés: nem szép a Claude-tól, hogy ilyen szamárságokat talál ki, hogy "prediktál". Ha latinizmusnak tekintjük, akkor legyen "predikál", ha nem, akkor legyen "prediktel", de ilyen öszvéreket ne tanuljunk már el a géptől.